تشير التقارير إلى أن 80% من البيانات ذات طابع بصري. تستخدم شركات مثل جوجل ومايكروسوفت نماذج اللغة البصرية (VLMs) لفهم هذه البيانات بشكل أفضل. تتيح هذه النماذج التعلم من الصور والنصوص على حد سواء، كما تدعم الإجابة عن الأسئلة البصرية وإضافة تسميات توضيحية للصور. من المرجح أن تُحدث هذه التقنيات تحولًا في طريقة استخدامنا لأجهزة الكمبيوتر والبحث عن المعلومات. كما أنها ضرورية لتطوير خدمات إدارة المواقع الافتراضية وحزمة برمجيات VLM.

توظف جوجل نماذج اللغة البصرية في منتجات مثل Google Lens، التي تحدد الأشياء وتقدم عنها معلومات. بالمثل، تدمج مايكروسوفت نماذج VLM ضمن Azure Computer Vision لتمكين المطورين من بناء تطبيقات قادرة على فهم البيانات البصرية. يكتسب استخدام نماذج VLM وحزم البرمجيات الخاصة بها رواجًا متزايدًا. إن فهم كيفية عملها وتطبيقاتها المحتملة سيكون أمرًا شيقًا. فقد تقلب نماذج VLM وخدمات إدارة المواقع الافتراضية العديد من الصناعات رأسًا على عقب — من التجارة الإلكترونية إلى الرعاية الصحية. وستكون الآثار الاقتصادية هائلة، لكن الاستخدامات الأكثر إثارة ستظهر مع تحسن هذه النماذج أكثر فأكثر، مما يجعل هذا الوقت مثيرًا لتقنيات VLM والذكاء البصري.

فهم أساسيات نماذج اللغة البصرية

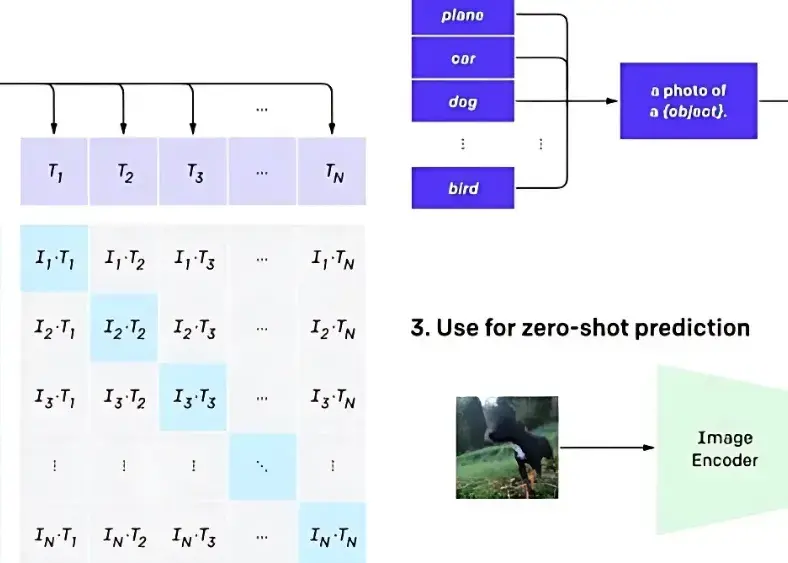

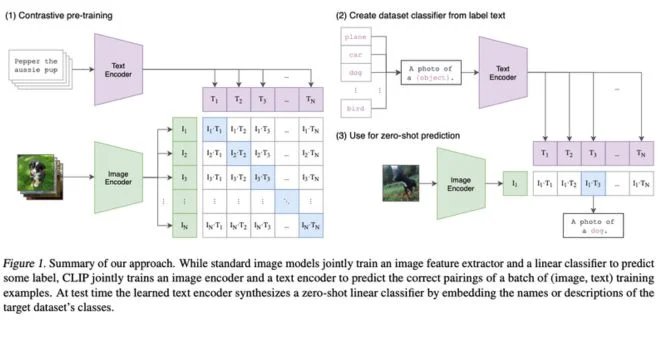

نماذج اللغة البصرية (VLMs) هي نوع من الذكاء الاصطناعي التي تساعد الحواسيب على تفسير البيانات البصرية. تتكون هذه النماذج من ثلاثة مكونات رئيسية: مُشفّر الرؤية، وجهاز إسقاط التضمينات، ومُفسّر النص. يعتني مُشفّر الرؤية بكل المدخلات البصرية مثل الصور والفيديوهات. يضمن جهاز الإسقاط توافق البيانات البصرية والنصية معًا، ثم يقوم المُفسّر بإنشاء الكلمات والنصوص بناءً على هذه التضمينات.

المكونات الأساسية لنماذج VLMs

تشمل بنية نماذج VLMs ثلاثة مفاهيم: مُشفّر الرؤية لمعالجة البيانات البصرية؛ وجهاز إسقاط التضمينات لربط البيانات البصرية والنصية، مما يجعل النموذج يفهم كلا النوعين؛ ثم يقوم بإنشاء مخرجات نصية تصف البيانات البصرية أو تضع تسميات توضيحية لها.

تطور الذكاء الاصطناعي البصري عبر العصور

تطورت تقنيات المعالجة البصرية بالذكاء الاصطناعي مع مرور الوقت، والآن دخلت نماذج VLMs المحسنة عالم الاستخدام الواسع. فهي تتعلم من مجموعات بيانات ضخمة وتزداد ذكاءً مع الزمن. وقد جعل هذا التطور ممكنًا تقديم خدمات إدارة المواقع الافتراضية واستراتيجيات المواقع الافتراضية، مما يدعم قطاعات متنوعة مثل التجارة الإلكترونية والرعاية الصحية.

يُستخدم حاليًا جزء من تقنية VLMs لتعزيز نتائج الأعمال، مثل خدمات إدارة المواقع الافتراضية التي تساعد في تتبع المخزون، في حين تُحسن استراتيجيات المواقع الافتراضية إدارة اللوجستيات وسلاسل التوريد.

التأثير الثوري لنماذج VLMs على الرؤية الرقمية

تغيّر نماذج VLMs الطريقة التي نطرح بها الأسئلة ونتفاعل مع الأجهزة الرقمية. فهي تجعل الكمبيوتر يفهم ويستخدم البيانات البصرية، مما يُسهم في تحسين سهولة الوصول ويزيد من كفاءة الاستخدام. تشكل حلول VLMs، بين أمور أخرى، التقنيات الأساسية للابتكارات المستقبلية مثل النظارات الذكية والسيارات ذاتية القيادة.

بفضل المزايا العديدة التي توفرها هذه التكنولوجيا، تُعتبر VLMs مغير لعبة في مجال الرؤية الرقمية. من بين أبرز الفوائد:

- تحسين إمكانية الوصول: تمكّن VLMs الأشخاص ذوي الإعاقات من استخدام الأجهزة الرقمية بسهولة أكبر.

- تجربة مستخدم أفضل: تجعل VLMs الأجهزة أكثر بديهية ومتعة في الاستخدام.

- زيادة الكفاءة: تقوم VLMs بأتمتة المهام، مما يجعل العمل أكثر إنتاجية وفعالية.

نحتاج إلى أدوات VLMs لتطوير حلول VLMs جديدة، مثل التعلم العميق ورؤية الكمبيوتر؛ فباستخدامها يمكننا ابتكار تطبيقات ثورية. إنها تعيد تعريف طريقة استخدامنا للأجهزة الرقمية والبحث عن المعلومات.

فعلاً، التأثير الذي تحدثه نماذج VLMs على الرؤية الرقمية كبير، لأنها تمتلك القدرة على تغيير كيفية استخدامنا للأجهزة الرقمية والبحث عن المعلومات. ومع استمرار تطور هذه التكنولوجيا، سنشهد المزيد من التطبيقات والحلول المذهلة في المستقبل.

| فوائد VLMs | الوصف |

|---|---|

| تحسين إمكانية الوصول | تسهل VLMs على ذوي الإعاقات استخدام الأجهزة الرقمية. |

| تعزيز تجربة المستخدم | تجعل VLMs استخدام الأجهزة أكثر بديهية ومتعة. |

| زيادة الكفاءة | تقوم VLMs بأتمتة المهام، مما يزيد من الإنتاجية والفعالية. |

البنية التقنية لنماذج VLMs الحديثة

تشكل الشبكات العصبية المعقدة أساس نماذج VLMs الحديثة. وتُعد القدرة الحاسوبية المتوفرة عبر الآلات الافتراضية باستخدام برامج تشغيل الآلة الافتراضية ضرورية لتوفير بيئات افتراضية مرنة وقابلة للتوسع وإدارة مواردها بسهولة.

تحتوي بنية VLMs على الأجزاء المهمة التالية:

- أساس الشبكات العصبية: تتكامل الشبكات العصبية التلافيفية والتكرارية لتعلم الأنماط البصرية والعلاقات بينها وبين النصوص.

- متطلبات البيانات للتدريب: يحتاج كل نموذج VLM عادةً إلى ملايين الصور والنصوص للتدريب على نطاق واسع.

نظرة عامة على خط أنابيب المعالجة: يمر المعالج بعدة مراحل، بما في ذلك ما قبل معالجة البيانات، واستخراج الميزات، وتدريب النموذج، وكلها تستفيد من الأدوات الافتراضية لتعزيز الأداء.

| المكون | الوصف |

|---|---|

| أساسيات الشبكات العصبية | الشبكات العصبية التلافيفية (CNNs) والتكرارية (RNNs) |

| متطلبات بيانات التدريب | ملايين الصور والنصوص |

| نظرة عامة على خط الأنابيب | ما قبل المعالجة، واستخراج الميزات، وتدريب النموذج |

كيفية معالجة نماذج VLMs وفهم المعلومات البصرية

تستخدم هذه النماذج رؤية الكمبيوتر والتعلم العميق لاستخلاص المعاني من الصور والفيديوهات. يمكنها اكتشاف الكائنات والمشاهد والإجراءات الممثلة في البيانات البصرية.

تُدرَّب النماذج على استخراج الميزات وتمييز الأنماط والعلاقات بين المعلومات البصرية والنصية. تلعب الحلول الافتراضية وأدوات الحوسبة السحابية دورًا حيويًا في نشر هذه النماذج وإدارتها، مما يجعل التعامل مع مجموعات البيانات الضخمة أكثر سهولة.

من فوائد نماذج VLMs:

- دقة أعلى في التعرف على الصور والفيديوهات

- استخلاص تفاصيل مفيدة من المحتوى البصري

- مقاربة تعزز الكفاءة في معالجة وتحليل مجموعات البيانات الضخمة

بفضل الحوسبة السحابية، تعمل نماذج VLMs في بيئة افتراضية دون الحاجة إلى بنية تحتية مادية، مما يتيح مرونة أكبر في التوسع. هذا يمكّن المؤسسات من التركيز على تحسين النماذج بدلاً من إدارة التقنية فقط.

مع تزايد انتشار نماذج VLMs، من المتوقع تحقيق المزيد من التقدم في حلول البيئات الافتراضية وخدمات الحوسبة السحابية، مما سيحسن معالجة وفهم البيانات البصرية بشكل أكبر.

استخدام نماذج اللغة البصرية مع المحولات

لإجراء الاستدلال باستخدام نموذج LlavaNext، اتبع الخطوات التالية:

تهيئة النموذج والمعالج

أولاً، استورد المكتبات الضرورية وقم بإعداد النموذج والمعالج:

pythonCopy codefrom transformers import LlavaNextProcessor, LlavaNextForConditionalGeneration

import torch

# Determine the device (GPU if available, otherwise CPU)

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# Load the processor and model from the pre-trained resources

processor = LlavaNextProcessor.from_pretrained("llava-hf/llava-v1.6-mistral-7b-hf")

model = LlavaNextForConditionalGeneration.from_pretrained(

"llava-hf/llava-v1.6-mistral-7b-hf",

torch_dtype=torch.float16,

low_cpu_mem_usage=True

)

model.to(device)

توليد المخرجات من الصور والموجهات

بعد ذلك، قم بمعالجة الصورة المدخلة وموجه النص قبل تمريرهما إلى النموذج للتوليد:

pythonCopy codefrom PIL import Image

import requests

# Load an image from a URL

url = "https://github.com/haotian-liu/LLaVA/blob/1a91fc274d7c35a9b50b3cb29c4247ae5837ce39/images/llava_v1_5_radar.jpg?raw=true"

image = Image.open(requests.get(url, stream=True).raw)

# Define the text prompt

prompt = "[INST] \nWhat is shown in this image? [/INST]"

# Process the inputs

inputs = processor(prompt, image, return_tensors="pt").to(device)

# Generate predictions

output = model.generate(**inputs, max_new_tokens=100)

# Decode and display the results

print(processor.decode(output[0], skip_special_tokens=True))

ضبط نماذج اللغة البصرية بدقة باستخدام TRL

تتضمن مكتبة TRL الآن دعمًا تجريبيًا لضبط نماذج اللغة البصرية (VLMs). هنا نوضح ضبط نموذج Llava 1.5 باستخدام مجموعة بيانات من أزواج الصور والمحادثات. تحتوي المجموعة على تفاعلات تصاحب كل صورة استفسارات المستخدم.

إعداد البيئة

تأكد من تثبيت أحدث إصدار من مكتبة TRL:

bashCopy codepip install -U trl

إعداد ضبط المعلمات

إليك كيفية إعداد ضبط المعلمات للتوجيه:

pythonCopy codefrom trl.commands.cli_utils import SftScriptArguments, TrlParser

# Parse arguments for fine-tuning

parser = TrlParser((SftScriptArguments, TrainingArguments))

args, training_args = parser.parse_args_and_config()

# Define the chat template

LLAVA_CHAT_TEMPLATE = """A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful, detailed, and polite answers to the user's questions. {% for message in messages %}{% if message['role'] == 'user' %}USER: {% else %}ASSISTANT: {% endif %}{% for item in message['content'] %}{% if item['type'] == 'text' %}{{ item['text'] }}{% elif item['type'] == 'image' %}{% endif %}{% endfor %}{% if message['role'] == 'user' %} {% else %}{{eos_token}}{% endif %}{% endfor %}"""

تهيئة النموذج والمحوّل

pythonCopy codefrom transformers import AutoTokenizer, AutoProcessor, LlavaForConditionalGeneration

# Load the model and tokenizer

model_id = "llava-hf/llava-1.5-7b-hf"

tokenizer = AutoTokenizer.from_pretrained(model_id)

tokenizer.chat_template = LLAVA_CHAT_TEMPLATE

processor = AutoProcessor.from_pretrained(model_id)

processor.tokenizer = tokenizer

model = LlavaForConditionalGeneration.from_pretrained(model_id, torch_dtype=torch.float16)

إنشاء جامع بيانات

لتحضير أزواج النصوص والصور للتدريب:

pythonCopy codeclass LLavaDataCollator:

def __init__(self, processor):

self.processor = processor

def __call__(self, examples):

texts = []

images = []

for example in examples:

messages = example["messages"]

text = self.processor.tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=False

)

texts.append(text)

images.append(example["images"][0])

batch = self.processor(texts, images, return_tensors="pt", padding=True)

labels = batch["input_ids"].clone()

if self.processor.tokenizer.pad_token_id is not None:

labels[labels == self.processor.tokenizer.pad_token_id] = -100

batch["labels"] = labels

return batch

data_collator = LLavaDataCollator(processor)

تحميل مجموعة البيانات

pythonCopy codefrom datasets import load_dataset

# Load the dataset

raw_datasets = load_dataset("HuggingFaceH4/llava-instruct-mix-vsft")

train_dataset = raw_datasets["train"]

eval_dataset = raw_datasets["test"]

تدريب النموذج

قم بتهيئة المدرب وابدأ عملية التدريب:

pythonCopy codefrom trl import SFTTrainer

trainer = SFTTrainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=eval_dataset,

dataset_text_field="text",

tokenizer=tokenizer,

data_collator=data_collator,

dataset_kwargs={"skip_prepare_dataset": True},

)

trainer.train()

# Save and push the model

trainer.save_model(training_args.output_dir)

trainer.push_to_hub()

تحليل التكلفة مقابل الفائدة لتنفيذ VLM

هذا مجرد أحد الطرق التي يمكن لنماذج اللغة البصرية من خلالها تحقيق كفاءة لمختلف أنواع المهام، بدءًا من العامة وحتى المهام المتخصصة. في الواقع، استخدام التكلفة لمقارنة الفوائد لكل الأنشطة التي تستخدم VLM يسهل معرفة ما إذا كانت هذه الأنشطة مستنزفة للموارد أم لا.

توفر VLMs خدمة عملاء أفضل، وزيادة في الإيرادات، وتخفيضًا في التكاليف. يمكن لأدوات تطوير VLM مثل SDKs وواجهات برمجة التطبيقات (APIs) تحسين الفوائد وتقليل التكاليف من خلال تطبيق حلول VLM مصممة خصيصًا لكل مؤسسة.

لإجراء تحليل تكلفة مقابل فائدة، تشمل البنود الرئيسية المتعلقة بالتكلفة:

- تكلفة التطوير: النفقات المتكبدة في تطوير وتثبيت حل VLM.

- تكلفة النشر: النفقات المتعلقة بنشر حل VLM ودمجه مع الأنظمة الأخرى.

- تكلفة الصيانة: النفقات المرتبطة بتشغيل حل VLM وإجراء التحديثات.

- الفوائد: المزايا المكتسبة مثل زيادة الكفاءة، ودقة أعلى، وتحسين خدمة العملاء.

من خلال تحليل هذه النقاط، يمكن للمؤسسة أن تقرر ما إذا كان اعتماد حل VLM مبررًا. مع الأدوات المناسبة والاستراتيجية الملائمة، يمكن تحقيق أقصى استفادة من VLMs، مما يؤدي إلى تحسينات كبيرة في أداء العمليات ودقة النتائج ورضا العملاء.

أفضل الممارسات لاعتماد VLMs

يتطلب اعتماد نماذج اللغة البصرية (VLMs) تخطيطًا وصيانةً مناسبين. يهدف تطبيق VLMs إلى تعزيز العمليات التجارية وتحسين اتخاذ القرارات. توفر شركات رائدة مثل جوجل ومايكروسوفت نماذج مدربة مسبقًا وواجهات برمجة تطبيقات APIs لتمكين المؤسسات من استخدام VLMs بسهولة عند الحاجة.

تتضمن خطة اعتماد VLMs التفصيلية ما يلي:

- خطة واضحة لاستخدام VLM: تحديد الأهداف والجداول الزمنية.

- تدريب المستخدمين على استخدام وصيانة VLM بفعالية.

- إنشاء برنامج للتحديثات الدورية وفحوصات الأمان لـ VLM.

استراتيجية التنفيذ

الخطة التفصيلية شرط أساسي لنجاح VLM، وتشمل جرد الأنظمة الحالية، وتحديد أماكن الدمج المحتملة لإضافة قيمة، ووضع خارطة طريق واضحة.

متطلبات تدريب الفريق

يعد تدريب الفريق بشكل جيد أمرًا حاسمًا لضمان استخدام VLM بفعالية. يقدم موردو VLM التدريب والدعم لمساعدة المؤسسات على البدء.

إجراءات الصيانة

الحفاظ على تحديث VLMs وأمنها أمر مهم: فالتحديثات ومراقبة التهديدات والفحوصات الدورية تمنع المشكلات.

قياس النجاح: مؤشرات الأداء الرئيسية لتطبيق VLM

من الضروري النظر في مؤشرات الأداء الرئيسية (KPIs) عند تقييم فعالية VLMs. لا تشير هذه المؤشرات إلى أداء النماذج فحسب، بل تمكّن المؤسسة من قياس تأثيرها على الأعمال. يسمح تتبع المؤشرات بتحديد مدى إسهام VLMs في مجالات الكفاءة والدقة والأداء العام، وتوجيه جهود التحسين.

من بين مؤشرات الأداء التي يجب قياسها:

- العائد على الاستثمار (ROI): يقيس الفائدة الاقتصادية من تطبيق VLM مقارنةً بالتكاليف والتوفيرات.

- رضا العملاء: يعكس مدى تقدير العملاء للخدمات المقدمة عبر VLM من حيث السرعة والدقة.

- الدقة: تقيس مدى صحة تفسيرات VLM مقارنةً بالبيانات الواقعية.

- التحديد: يقيم مدى اتساق مخرجات النموذج وموثوقيتها.

- الاسترجاع: يعكس قدرة VLM على اكتشاف المعلومات ذات الصلة.

باستخدام هذه المؤشرات، تستطيع المؤسسات تحسين استراتيجية VLM وضمان توافقها مع أهداف الأعمال وتحقيق فوائد ملموسة ومستدامة.

جدول مؤشرات الأداء الرئيسية لتقييم VLM

| المؤشر | الوصف |

|---|---|

| الدقة | تقيس مدى صحة تفسيرات VLM. |

| التحديد | تقيّم مدى تحديد معالجة VLM. |

| الاسترجاع | يعكس قدرة VLM على اكتشاف المعلومات ذات الصلة. |

المشكلات الشائعة التي يجب تجنبها عند نشر VLMs

يُعد نشر نموذج اللغة البصرية (VLM) داخليًا تحديًا كبيرًا. فهذه النماذج متطورة للغاية وتتطلب قدرًا هائلًا من التخطيط والتنفيذ لتعمل بشكل أمثل. من التحديات الرئيسية نقص بيانات التدريب؛ إذ يتأثر أداء VLM بنوعية البيانات، ويجب أن تكون متنوعة وعالية الجودة. كما يُعد نقص القدرة الحاسوبية خطأ شائعًا، فهذه النماذج تعتمد على موارد ضخمة وتتطلب بنية تحتية قوية.

علاوةً على ذلك، يجب تقييم مدى ملاءمة VLM لكل مهمة قبل نشره للتأكد من قدرته على التعامل مع التعقيد المطلوب. كما ينبغي مراقبة أداء VLM بانتظام في البيئات الحقيقية لتحديد مجالات التحسين. تساعد المراجعات الدورية بناءً على مؤشرات الأداء في الحفاظ على صحة الأنظمة وتجنب التراجع في الأداء.

أخيرًا، فإن الصيانة والدعم المستمرين ضروريان لاستدامة الربحية طويلة الأمد. تحتاج VLMs إلى تحديثات دورية ومراقبة مستمرة للمخاطر لتجنب تصبح قديمة أو تقل كفاءتها. توفر خدمات إدارة البيئات الافتراضية الخبرة والموارد اللازمة لنشر VLM ودمجه مع الأنظمة القائمة، ومراقبة الأداء، وصيانته على المدى الطويل.

الخاتمة: مستقبل معالجة الذكاء البصري

يتغير مستقبل تكنولوجيا معالجة اللغة البصرية بسرعة كبيرة. ساهمت التطورات في التعلم العميق ورؤية الكمبيوتر في تحسين معالجة الذكاء البصري، وتوعد التطبيقات بالتوسع في مجالات مثل التجارة الإلكترونية والرعاية الصحية. بفضل قدرته على التعلم من مجموعات بيانات ضخمة وآليات التحسين المستمر، ستغير VLMs طريقة تعاملنا مع البيانات البصرية والبحث عنها. مع اعتماد المؤسسات لـ VLMs، يصبح متابعة أحدث التقنيات وتطبيقاتها أمرًا حيويًا لتمكين الابتكار وزيادة الكفاءة وتحسين خدمة العملاء.